Willkommen bei Safersurfing

Wir freuen uns, dass du uns in den Weiten des Web gefunden hast! Die globale Digitalisierung ist Möglichkeit und Herausforderung zugleich. Internetpornografie ist allgegenwärtig und hält bereits Einzug in die Kinderzimmer. Bei Safersurfing findest du viel Wissenswertes zu Kinderschutz, Hilfe bei Abhängigkeit sowie Fakten zum Thema.

Kernaussagen & Highlights von Experten-Panels

Unsere letzten Beiträge

Handyverbot an österreichischen Pflichtschulen

Die Diskussion um die Handynutzung an österreichischen Schulen wurde neu entfacht. Immer mehr Bundesländer interessieren sich für ein generelles Handyverbot an Pflichtschulen

Familiengesundheitsberatung – Elisabeth Schmidt im Interview

Wenn das Familienleben schief steht und ein harmonisches Zusammenleben nicht mehr möglich scheint, dann ist Hilfe von außen oft die rettende Lösung. Familienberaterin Elisabeth Schmidt im Safersurfing-Interview.

Australien – Kein Social Media unter 16 Jahren

Australien hat ein Gesetz verabschiedet, das Kindern und Jugendlichen unter 16 Jahren den Zugang zu sozialen Medien untersagt. Das Gesetz gilt weltweit als erstes seiner Art.

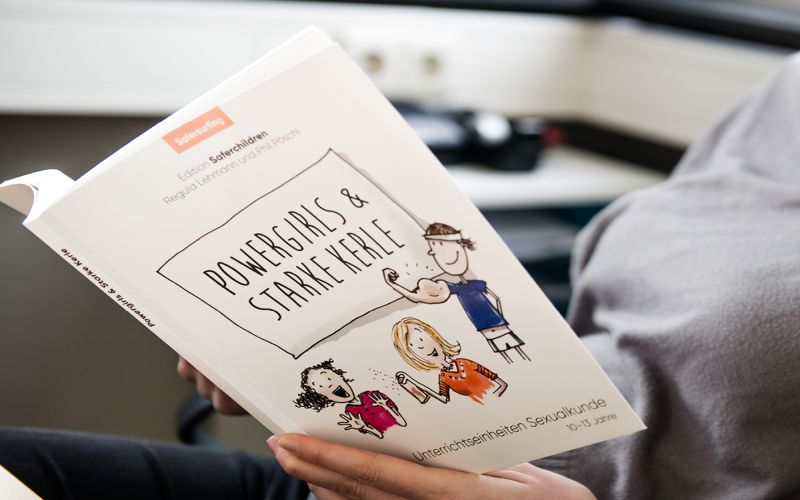

Newsletter – Powergirls & Starke Kerle

Unterstützung von Eltern und Schule bei der Medien- und Sexualerziehung - Powergirls & Starke Kerle.

WHO-Bericht: Schädliche Online-Gewohnheiten bei Jugendlichen

Ein neuer Bericht der WHO zeigt: Immer mehr Jugendliche legen ungesunde Online-Gewohnheiten an den Tag. Problematisches Gaming-Verhalten und sucht-ähnliche Symptome in Zusammenhang mit Social Media.

Instagram Teen Accounts – Ein Schritt in die richtige Richtung

Instagram reagiert auf immer lauter werdenden politischen Druck und kündigt Nutzerkonten für Minderjährige an. Bis Jahresende sollen die Teen Accounts flächendeckend die EU erreichen.

Auf Social Media